机器视觉系统通过三维感知、多传感器融合、深度学习算法、实时环境建模、智能交互决策五大核心技术,为机器人赋予“看懂世界”的能力,推动其向更高阶的智能化演进。以下是具体技术路径与前沿应用分析:

一、三维感知:从平面到立体的视觉革命

传统2D视觉受限于信息维度,难以处理复杂曲面、透明物体或遮挡场景。3D视觉技术通过立体摄像头、飞行时间传感器(ToF)、结构光投影等手段,构建精确的物理世界模型,成为机器人视觉的核心突破口:

- 工业机器人:在半导体封装中,3D视觉引导机械臂精准抓取芯片,定位精度达0.02mm;汽车焊接车间通过3D点云重建实现多型号零部件的自适应抓取,减少人工干预。

- 服务机器人:INDEMIND的RBN10家用机器人平台,利用双目视觉创建环境语义地图,支持自主寻路、避障及交互,成本仅为激光融合方案的1/3。

- 自动驾驶:3D视觉与激光雷达融合,实现360度环视感知,精准识别行人、车辆及障碍物,提升决策安全性。

二、多传感器融合:构建冗余感知体系

单一传感器存在局限性,机器视觉与激光雷达、雷达、超声波等融合,形成“视觉+激光+雷达”的多模态感知网络:

- 环境适应性增强:在强光、雨雪等恶劣条件下,激光雷达补充视觉系统的深度数据;雷达监测高速运动物体,弥补视觉延迟。

- 动态场景处理:物流机器人通过视觉识别包裹尺寸,结合激光雷达规划路径,实现动态分拣效率提升3倍。

- 安全冗余设计:自动驾驶汽车采用“视觉主导+激光雷达验证”架构,确保在单一传感器失效时仍能安全行驶。

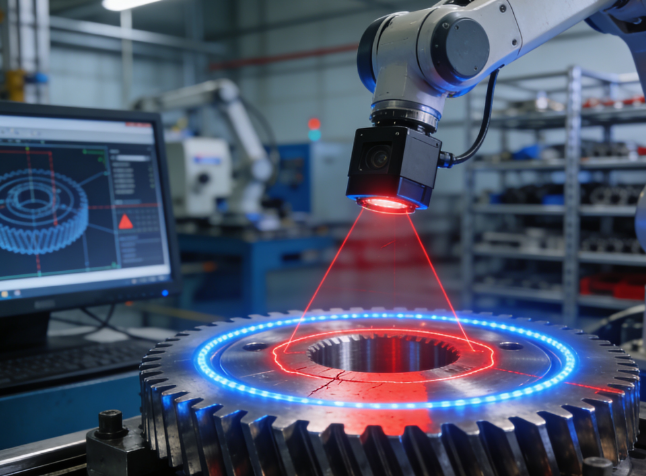

三、深度学习算法:从识别到认知的智能跃迁

深度学习赋予机器人理解复杂场景的能力,推动视觉系统从“规则驱动”转向“认知智能”:

- 目标检测与分类:YOLO等算法实现实时识别,在工业质检中检测缺陷的准确率超99%,误检率低于0.1%。

- 语义分割与场景理解:将图像像素按类别分类(如地板、工具、人员),支持机器人理解空间关系,例如在餐厅中区分餐桌与通道,规划最优路径。

- 小样本学习:通过迁移学习技术,仅需少量样本即可训练模型,降低数据标注成本,加速新场景部署。

四、实时环境建模:动态交互的底层支撑

视觉SLAM(同步定位与地图构建)技术使机器人能在未知环境中实时构建地图并定位自身:

- 自主导航:仓储机器人通过SLAM绘制仓库布局,结合视觉避障,实现动态路径规划,效率较传统AGV提升50%。

- 人机协作:在汽车装配线中,机器人通过视觉SLAM跟踪工人动作,调整协作节奏,避免碰撞。

- 探索未知领域:救援机器人利用SLAM在废墟中构建3D地图,标记幸存者位置,为救援提供决策依据。

五、智能交互决策:从感知到行动的闭环

机器视觉与AI决策系统结合,使机器人能根据视觉输入做出复杂响应:

- 姿态与情绪识别:服务机器人通过视觉分析人类表情、手势及肢体语言,理解交互意图,例如在养老场景中识别老人跌倒风险并预警。

- 动态任务调整:农业机器人根据果实成熟度视觉检测结果,实时调整采摘策略,减少损耗。

- 多模态交互:结合语音、触觉反馈,机器人能通过视觉线索(如用户注视方向)预测需求,提供主动服务。

前沿技术趋势:开启下一代视觉智能

- 量子计算赋能:量子算法可大幅提升图像处理速度,未来可能实现高维图像的实时分析。

- 仿生视觉模型:如香港大学提出的OverLoCK架构,模拟人类视觉“先概览全局,后聚焦细节”的机制,提升复杂场景处理效率。

- 边缘计算与云边协同:将算法部署至车载边缘设备,降低延迟,同时通过云端模型持续优化,提升系统适应性。

- 轻量化与模块化设计:微型传感器和模块化设计降低部署成本,推动中小型企业普及机器视觉技术。